Omniverse Audio2Faceでリップシンクアニメーションを作ってみた

音声に合わせて話しているように見えるフェイスアニメーションを作る時、一つひとつの言葉に合わせてキーを打つ作業はかなり大変ですよね…🤔

特にリアルタイムに生成された音声に口の動きを合わせようと思うと、自力ではなかなか難しかったり…

そんな時に、簡単にフェイスアニメーションを作成できるツールがOmniverse Audio2Faceです!

今回はAudio2Faceを活用して、簡単にリップシンクアニメーションを作成する方法を紹介します。

Omniverse Audio2Faceとは?

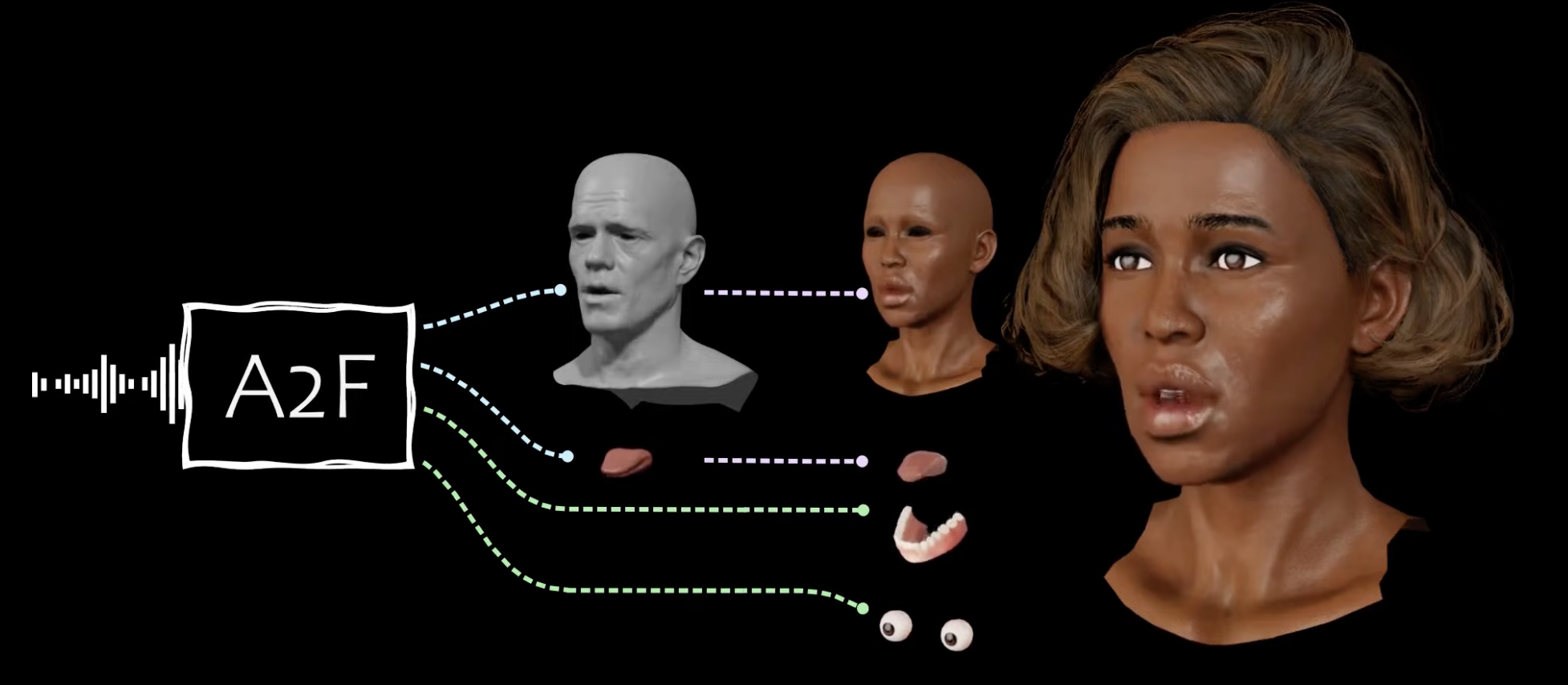

Omniverse Audio2Faceは、NVIDIAが開発・提供している生成AIを利用した音声ソースだけで表情豊かな顔のアニメーションが作成できるツールです。

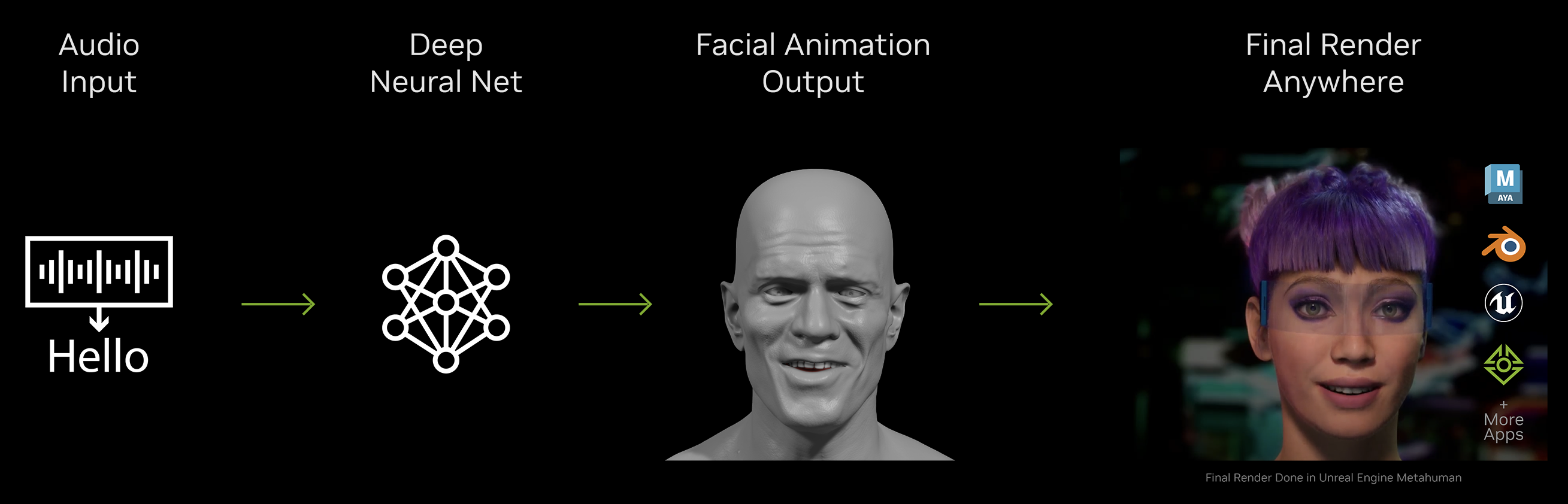

仕組み

-

入力した音声がトレーニング済みのディープニューラルネットワークに送られ、その出力によってキャラクターメッシュの3D頂点が動き、顔のアニメーションがリアルタイムで生成されます

-

Blender、Unreal Engine、Unityなど主要な3Dエンジンへのエクスポートも簡単に行うことができ、パラメータを編集することで生成されたアニメーションを編集することも可能です

特徴

-

アニメーションのリアルタイム生成が可能!

- マイクを接続すると、入力した音声に対してライブで顔のアニメーションを生成することもできます

-

感情に合わせた表情コントロールが可能!

-

選択した感情とカスタマイズした強度に合わせて、顔・目・舌・頭の動きをコントロールすることが可能です

-

オーディオクリップから感情を自動的に推論することもできます

-

Audio2Faceでリップシンクアニメーションを作成する

動作環境

-

Windows11

-

Omniverse Audio2Face 2023.2.0

Omniverse Audio2Faceを起動する

※ 下記サイトよりOmniverse Launcherのインストールが可能です

【手順】

-

Omniverse Launcherの「ライブラリ」タブを開く

-

アプリケーション内「Audio2Face」を選択し「スタート」をクリックする

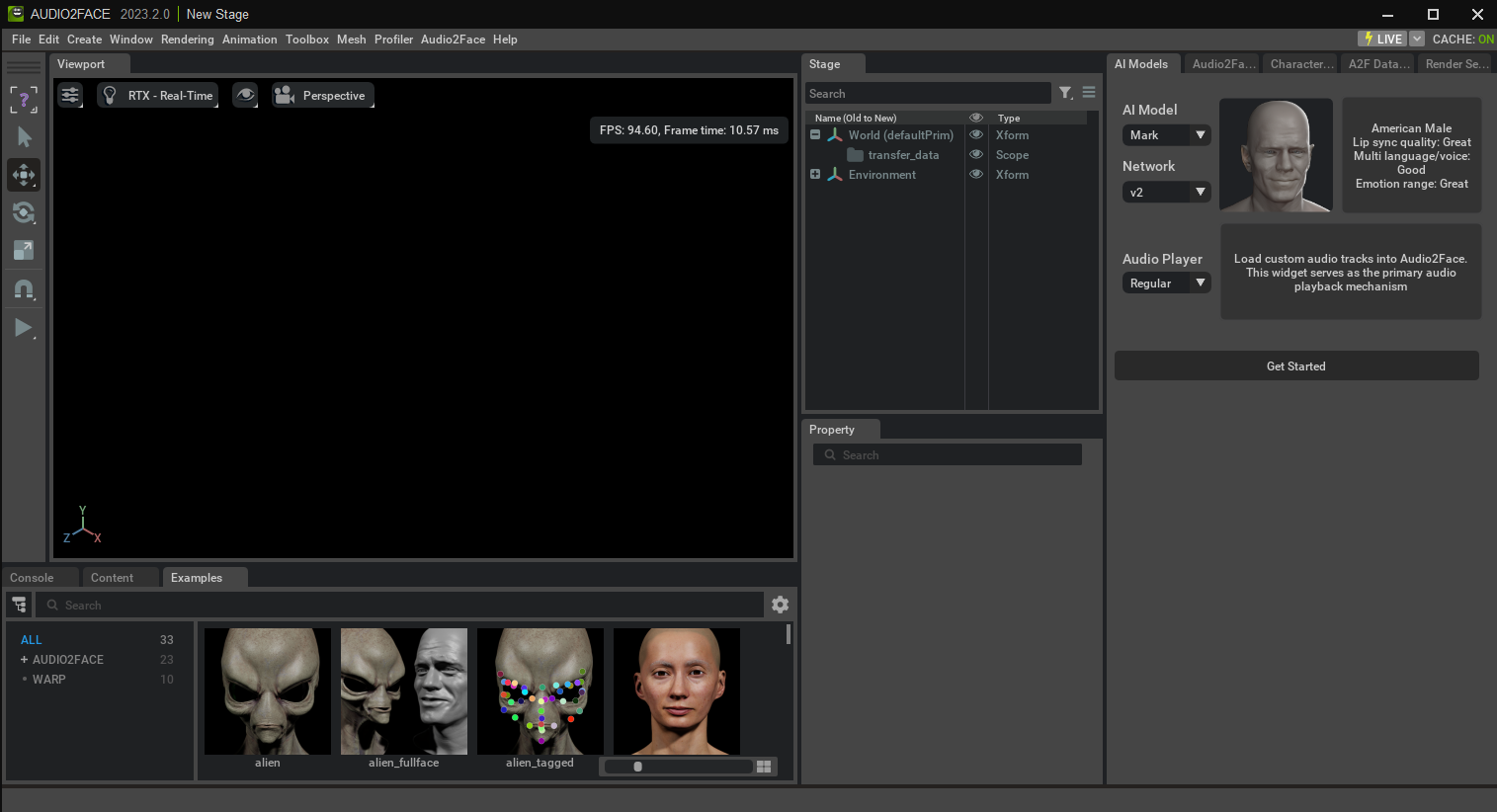

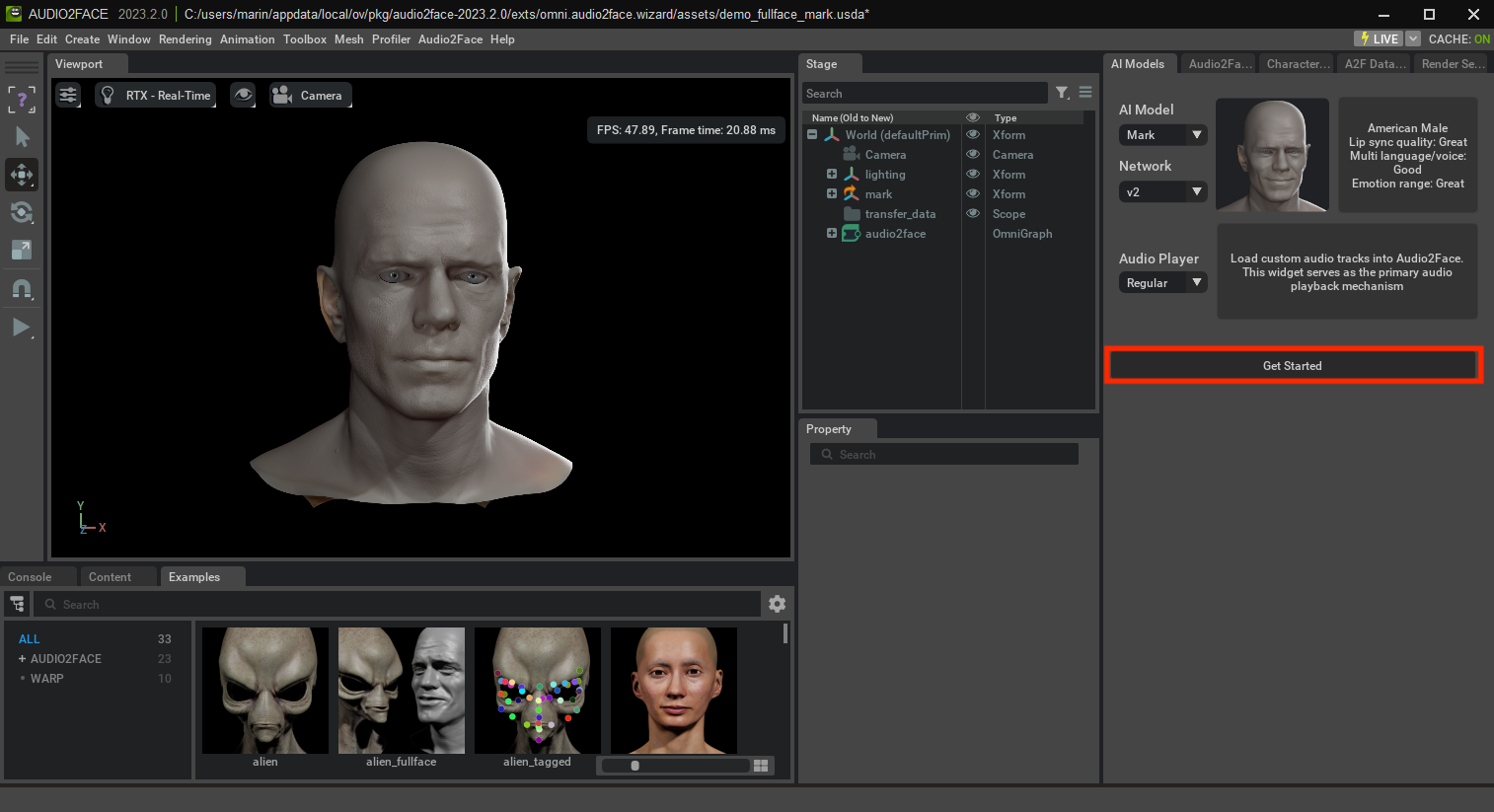

起動には少し時間がかかりますが、少し待つと以下のような画面が表示されます。

この画面が表示されたら、起動完了!

デフォルトのAI Modelを読み込む

【手順】

- 「AI Models」タブでベースとなるモデルを選択し、「Get Started」をクリックする

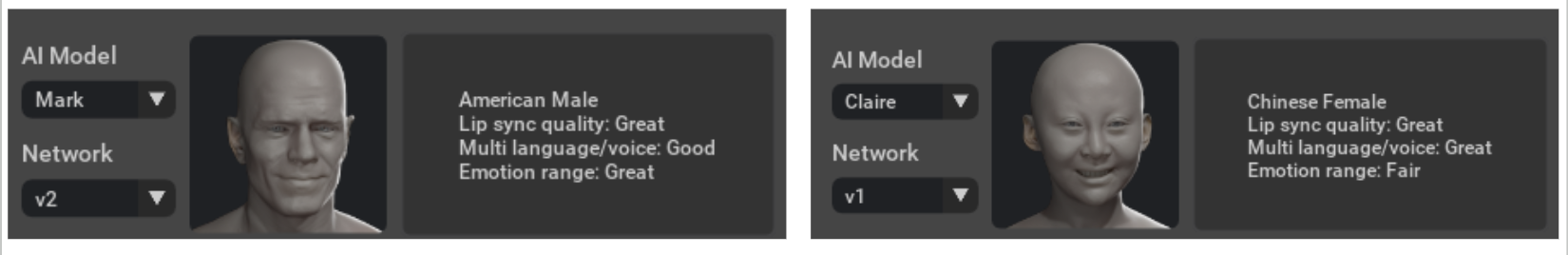

▼ デフォルトのAI Modelは2種類(Mark (左) か Claire (右) から選択)

音声に合わせてリップシンクアニメーションを動かす

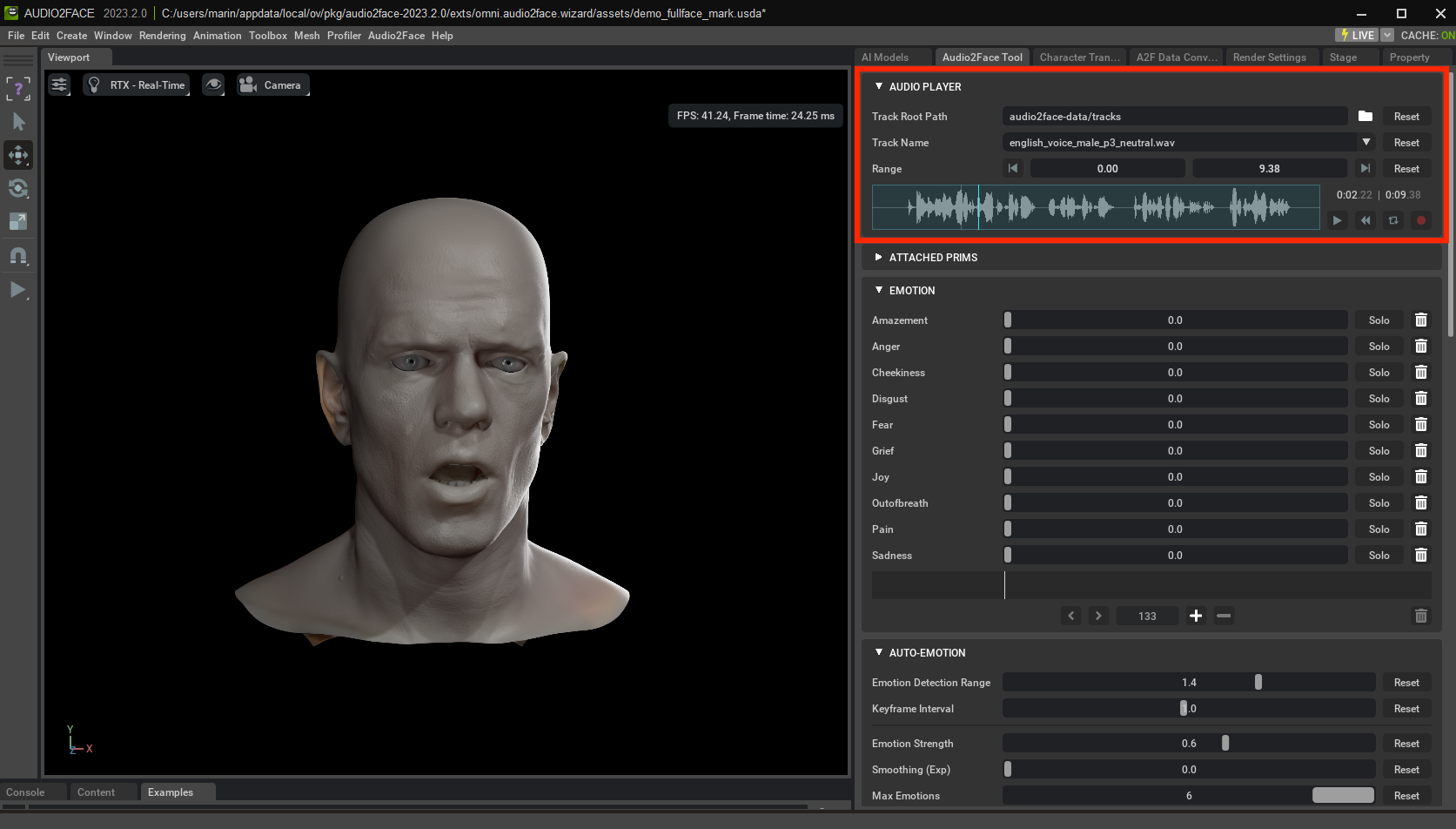

【手順】

-

「Audio2Face Tool」タブの「AUDIO PLAYER」欄の再生ボタンをクリックする

※ デフォルトではニュートラルに話す英語のデモ音声がセットされています

-

音声に合わせてモデルの口が動くことが確認できればOK!

(オリジナル音声でテストする場合) 音声ファイルをセットする

【手順】

-

「Audio2Face Tool」タブの「AUDIO PLAYER」内「Track Root Path」に音声ファイルのあるディレクトリを指定

-

「Track Name」に対象の音声ファイルを指定

-

音声を再生し、AI Modelの口が動くことが確認できればOK!

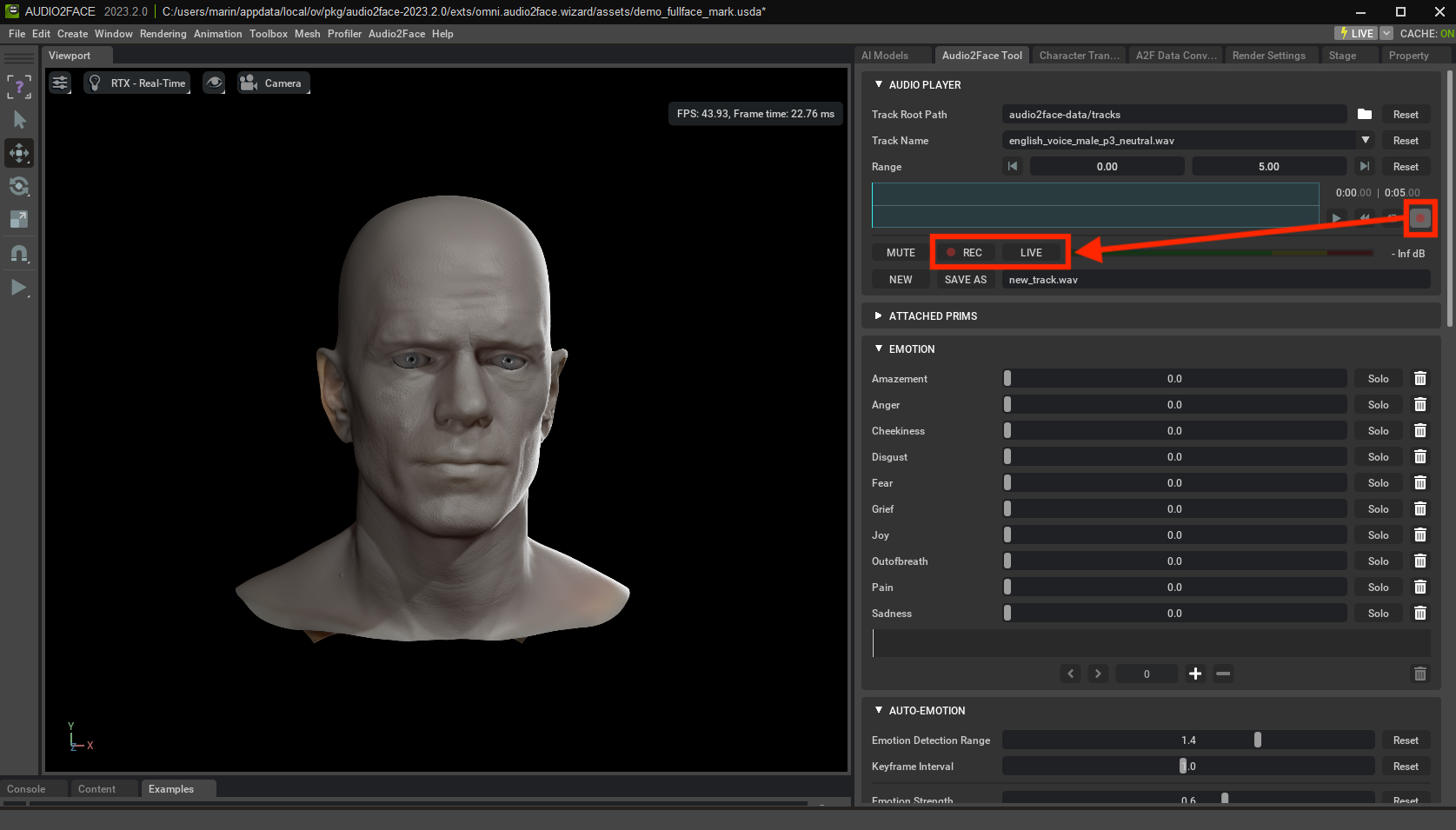

(アニメーションをリアルタイムに反映させる場合) LIVEモードにする

【手順】

-

「赤丸」をクリックした後、「LIVE」をクリックする

-

マイクなどからインプットした音声に対して、リアルタイムにAI Modelの口が動くことが確認できればOK!

※ マイクのインプットが確認されない場合、赤丸ボタンをクリックしてもREC・LIVEなどのボタンは表示されないので注意が必要です

※ 「REC」をクリックしてから音声を入力すると、リアルタイムにアニメーション生成もされますが、後から再度再生することも可能です

動作デモ

「Audio2Face Tool」タブの「EMOTION」内にあるスライダーを調整することで、表情に変化させることができます。

表現できる感情は、驚き・怒り・生意気さ・嫌悪・恐れ・喪失感・喜び・焦り・苦痛・悲しみの10種類。

様々な感情を少しずつ掛け合わせることで、場面に応じた絶妙な表情を作ることが可能です。

また、音声から自動で感情を読み取り、表情に反映させたい場合は「AUTO-EMOTION」内の項目を調整し、「GENERATE EMOTION KEYFRAMES」をクリックすると自動生成することも可能です。

その他、話す時の頭の動きやまばたきの頻度・速度、目の動き、口の開き具合など、細かく設定することもできます。

表情を変えて動作デモを行ってみました!

※ 英語バージョンで使用した音声は、デフォルトで用意されているデモ用の音声です

▼ 無表情 (英語) ver.

▼ Joy Max (英語) ver.

▼ Anger Max (英語) ver.

▼ 無表情 (日本語) ver.

まとめ

Omniverse Audio2Faceを活用して、音声をもとにリップシンクアニメーションを作成する流れを紹介しました。

今回はツール内で用意されているデフォルトのAI Modelを動かしましたが、自分で作成した3DモデルをインポートすることでAudio2Face上で様々なキャラクターを動かすこともできます!

(もちろん書き出したアニメーションを別の3Dエンジンで、自作のキャタクターに適用することも可能です🙌)

英語に比べると、日本語の口の動きはほんの少し正確さが劣るように感じる部分もありますが、ライブモードの遅延もほとんどなく、非常にスムーズです。

誰でも簡単に高クオリティなアニメーションを作成することができるので、CG初心者の方にもおすすめしたいツールです。様々な場面で活用していきたいですね!